Modelos médicos de IA se basan en ‘atajos’ que podrían conducir a diagnósticos equivocados de la COVID-19

|

Por el equipo editorial de LabMedica en español Actualizado el 29 Jun 2021 |

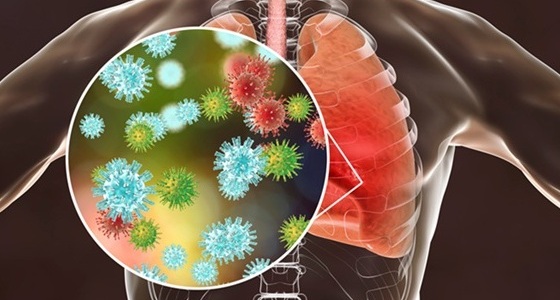

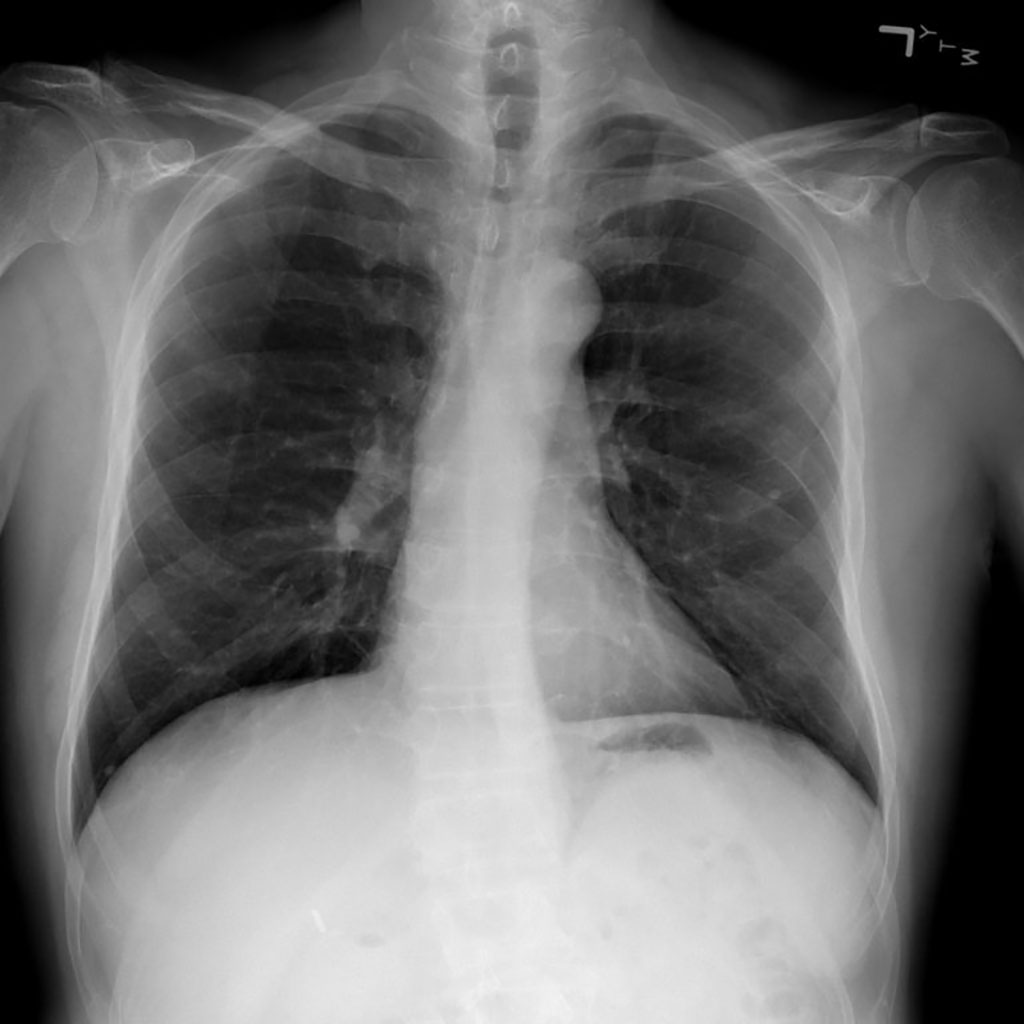

Imagen: Los modelos de IA médica confían en ‘atajos’ que podrían conducir a un diagnóstico erróneo de la COVID-19 (Fotografía cortesía del Centro Clínico de los Institutos Nacionales de Salud)

Los investigadores han descubierto que los modelos de inteligencia artificial médica (IA) se basan en ‘atajos’ que podrían conducir a un diagnóstico erróneo de la COVID-19 y otras enfermedades.

Investigadores de la Facultad de Ciencias e Ingeniería Informática Paul G. Allen de la Universidad de Washington (Seattle, WA, EUA), descubrieron que los modelos de IA, al igual que los humanos, tienden a buscar atajos. En el caso de la detección de enfermedades asistida por IA, tales atajos podrían dar lugar a errores de diagnóstico si se implementan en entornos clínicos. La IA promete ser una herramienta poderosa para mejorar la velocidad y exactitud de la toma de decisiones médicas para mejorar los resultados de los pacientes. Desde el diagnóstico de enfermedades hasta la personalización del tratamiento y la predicción de las complicaciones de la cirugía, la IA podría convertirse en una parte integral de la atención del paciente en el futuro, como lo son hoy las pruebas de diagnóstico por imágenes y de laboratorio.

Sin embargo, cuando los investigadores examinaron varios modelos presentados recientemente como herramientas potenciales para detectar con precisión la COVID-19 a partir de una radiografía de tórax (rayos X), encontraron que, en lugar de aprender una patología médica genuina, estos modelos se basan en el aprendizaje de atajos para dibujar imágenes falsas, asociaciones entre factores médicamente irrelevantes y el estado de la enfermedad. En este caso, los modelos ignoraron los indicadores clínicamente significativos a favor de características como los marcadores de texto o la posición del paciente que eran específicas de cada conjunto de datos para predecir si un individuo tenía COVID-19. Según los investigadores, el aprendizaje de atajos es menos sólido que la patología médica genuina y, por lo general, significa que el modelo no se generalizará bien fuera del entorno original. Combine esa falta de robustez con la opacidad típica de la toma de decisiones de la IA y una herramienta de este tipo podría pasar de ser un posible salvavidas para convertirse en un peligro.

La falta de transparencia es uno de los factores que llevó a los investigadores a centrarse en técnicas de IA explicables para la medicina y la ciencia. Se considera que la mayoría de la IA es como una “caja negra”: el modelo se entrena en conjuntos de datos masivos y arroja predicciones sin que nadie sepa realmente con precisión cómo fue que el modelo obtuvo un resultado determinado. Con una IA explicable, los investigadores y los profesionales pueden comprender, en detalle, cómo varias entradas y sus pesos contribuyeron al reporte hecho por el modelo. El equipo decidió utilizar estas mismas técnicas para evaluar la confiabilidad de los modelos que habían sido promocionados recientemente por lo que parecía ser su capacidad para identificar con exactitud los casos de COVID-19 a partir de una radiografía de tórax.

A pesar de una serie de artículos publicados que anuncian los resultados, los investigadores sospecharon que es posible que algo más suceda dentro de la caja negra que llevó a las predicciones de los modelos. Específicamente, razonaron que tales modelos serían propensos a una condición conocida como confusión del peor de los casos, debido a la escasez de datos de entrenamiento disponibles para una enfermedad tan nueva. Tal escenario aumentó la probabilidad de que los modelos se basen en atajos en lugar de aprender la patología subyacente de la enfermedad a partir de los datos de entrenamiento.

El equipo entrenó múltiples redes neuronales convolucionales profundas en imágenes de radiografía de un conjunto de datos que replicaba el enfoque utilizado en los artículos publicados. Probaron el rendimiento de cada modelo en un conjunto interno de imágenes de ese conjunto de datos inicial que se había retenido de los datos de entrenamiento y en un segundo conjunto de datos externo destinado a representar nuevos sistemas hospitalarios. Descubrieron que, si bien los modelos mantuvieron su alto rendimiento cuando se probaron en imágenes del conjunto de datos interno, su precisión se redujo a la mitad en el segundo conjunto externo, lo que los investigadores denominaron una brecha de generalización y citaron una fuerte evidencia de que los factores de confusión fueron responsables del éxito predictivo de los modelos en el conjunto de datos inicial. Luego, el equipo aplicó técnicas de inteligencia artificial explicables, incluidas las redes generativas adversarias (GAN) y los mapas de prominencia, para identificar qué características de la imagen eran más importantes para determinar las predicciones de los modelos.

Cuando los investigadores entrenaron los modelos en el segundo conjunto de datos, que contenía imágenes extraídas de una sola región y, por lo tanto, se presumió que era menos propenso a generar confusión, resultó no ser el caso; incluso esos modelos mostraron una caída correspondiente en el desempeño cuando se probaron con datos externos. Estos resultados anulan la sabiduría convencional de que la confusión plantea un problema menor cuando los conjuntos de datos se derivan de fuentes similares, y revelan hasta qué punto los llamados sistemas de IA médica de alto rendimiento podrían explotar atajos indeseables en lugar de las señales deseadas. A pesar de las preocupaciones planteadas por sus hallazgos, los investigadores creen que es poco probable que los modelos que estudiaron se hayan implementado ampliamente en el entorno clínico. Si bien hay evidencia de que al menos uno de los modelos defectuosos, COVID-Net, se implementó en varios hospitales, no está claro si se utilizó con fines clínicos o únicamente para la investigación. Según el equipo, los investigadores que buscan aplicar la IA a la detección de enfermedades deberán renovar su enfoque antes de que dichos modelos se puedan usar para tomar decisiones de tratamiento reales para los pacientes.

“Un modelo que se basa en atajos a menudo solo funcionará en el hospital en el que se desarrolló, por lo que cuando se lleva el sistema a un nuevo hospital, falla, y esa falla puede dirigir a los médicos hacia un diagnóstico y un tratamiento incorrectos”, explicó el estudiante de posgrado y coautor principal, Alex DeGrave. “Un médico generalmente esperaría que un hallazgo de COVID-19 en una radiografía se basara en patrones específicos en la imagen que reflejan los procesos de la enfermedad. Pero en lugar de depender de esos patrones, un sistema que utilice el aprendizaje de atajos podría, por ejemplo, juzgar que alguien es mayor y, por lo tanto, inferir que es más probable que tenga la enfermedad porque es más común en pacientes mayores. El atajo no es incorrecto per se, pero la asociación es inesperada y no transparente. Y eso podría llevar a un diagnóstico inadecuado”.

“Nuestros hallazgos apuntan a la importancia de aplicar técnicas de inteligencia artificial explicables para auditar rigurosamente los sistemas de inteligencia artificial médica”, dijo el coautor principal Joseph Janizek. “Si miras un puñado de rayos X, el sistema de IA puede parecer que se comporta bien. Los problemas solo se aclaran una vez que miras muchas imágenes. Hasta que tengamos métodos para auditar estos sistemas de manera más eficiente utilizando un tamaño de muestra mayor, una aplicación más sistemática de IA explicable podría ayudar a los investigadores a evitar algunos de los errores que identificamos con los modelos COVID-19”.

Enlace relacionado:

Facultad de Ciencias e Ingeniería Informática Paul G. Allen de la Universidad de Washington

Investigadores de la Facultad de Ciencias e Ingeniería Informática Paul G. Allen de la Universidad de Washington (Seattle, WA, EUA), descubrieron que los modelos de IA, al igual que los humanos, tienden a buscar atajos. En el caso de la detección de enfermedades asistida por IA, tales atajos podrían dar lugar a errores de diagnóstico si se implementan en entornos clínicos. La IA promete ser una herramienta poderosa para mejorar la velocidad y exactitud de la toma de decisiones médicas para mejorar los resultados de los pacientes. Desde el diagnóstico de enfermedades hasta la personalización del tratamiento y la predicción de las complicaciones de la cirugía, la IA podría convertirse en una parte integral de la atención del paciente en el futuro, como lo son hoy las pruebas de diagnóstico por imágenes y de laboratorio.

Sin embargo, cuando los investigadores examinaron varios modelos presentados recientemente como herramientas potenciales para detectar con precisión la COVID-19 a partir de una radiografía de tórax (rayos X), encontraron que, en lugar de aprender una patología médica genuina, estos modelos se basan en el aprendizaje de atajos para dibujar imágenes falsas, asociaciones entre factores médicamente irrelevantes y el estado de la enfermedad. En este caso, los modelos ignoraron los indicadores clínicamente significativos a favor de características como los marcadores de texto o la posición del paciente que eran específicas de cada conjunto de datos para predecir si un individuo tenía COVID-19. Según los investigadores, el aprendizaje de atajos es menos sólido que la patología médica genuina y, por lo general, significa que el modelo no se generalizará bien fuera del entorno original. Combine esa falta de robustez con la opacidad típica de la toma de decisiones de la IA y una herramienta de este tipo podría pasar de ser un posible salvavidas para convertirse en un peligro.

La falta de transparencia es uno de los factores que llevó a los investigadores a centrarse en técnicas de IA explicables para la medicina y la ciencia. Se considera que la mayoría de la IA es como una “caja negra”: el modelo se entrena en conjuntos de datos masivos y arroja predicciones sin que nadie sepa realmente con precisión cómo fue que el modelo obtuvo un resultado determinado. Con una IA explicable, los investigadores y los profesionales pueden comprender, en detalle, cómo varias entradas y sus pesos contribuyeron al reporte hecho por el modelo. El equipo decidió utilizar estas mismas técnicas para evaluar la confiabilidad de los modelos que habían sido promocionados recientemente por lo que parecía ser su capacidad para identificar con exactitud los casos de COVID-19 a partir de una radiografía de tórax.

A pesar de una serie de artículos publicados que anuncian los resultados, los investigadores sospecharon que es posible que algo más suceda dentro de la caja negra que llevó a las predicciones de los modelos. Específicamente, razonaron que tales modelos serían propensos a una condición conocida como confusión del peor de los casos, debido a la escasez de datos de entrenamiento disponibles para una enfermedad tan nueva. Tal escenario aumentó la probabilidad de que los modelos se basen en atajos en lugar de aprender la patología subyacente de la enfermedad a partir de los datos de entrenamiento.

El equipo entrenó múltiples redes neuronales convolucionales profundas en imágenes de radiografía de un conjunto de datos que replicaba el enfoque utilizado en los artículos publicados. Probaron el rendimiento de cada modelo en un conjunto interno de imágenes de ese conjunto de datos inicial que se había retenido de los datos de entrenamiento y en un segundo conjunto de datos externo destinado a representar nuevos sistemas hospitalarios. Descubrieron que, si bien los modelos mantuvieron su alto rendimiento cuando se probaron en imágenes del conjunto de datos interno, su precisión se redujo a la mitad en el segundo conjunto externo, lo que los investigadores denominaron una brecha de generalización y citaron una fuerte evidencia de que los factores de confusión fueron responsables del éxito predictivo de los modelos en el conjunto de datos inicial. Luego, el equipo aplicó técnicas de inteligencia artificial explicables, incluidas las redes generativas adversarias (GAN) y los mapas de prominencia, para identificar qué características de la imagen eran más importantes para determinar las predicciones de los modelos.

Cuando los investigadores entrenaron los modelos en el segundo conjunto de datos, que contenía imágenes extraídas de una sola región y, por lo tanto, se presumió que era menos propenso a generar confusión, resultó no ser el caso; incluso esos modelos mostraron una caída correspondiente en el desempeño cuando se probaron con datos externos. Estos resultados anulan la sabiduría convencional de que la confusión plantea un problema menor cuando los conjuntos de datos se derivan de fuentes similares, y revelan hasta qué punto los llamados sistemas de IA médica de alto rendimiento podrían explotar atajos indeseables en lugar de las señales deseadas. A pesar de las preocupaciones planteadas por sus hallazgos, los investigadores creen que es poco probable que los modelos que estudiaron se hayan implementado ampliamente en el entorno clínico. Si bien hay evidencia de que al menos uno de los modelos defectuosos, COVID-Net, se implementó en varios hospitales, no está claro si se utilizó con fines clínicos o únicamente para la investigación. Según el equipo, los investigadores que buscan aplicar la IA a la detección de enfermedades deberán renovar su enfoque antes de que dichos modelos se puedan usar para tomar decisiones de tratamiento reales para los pacientes.

“Un modelo que se basa en atajos a menudo solo funcionará en el hospital en el que se desarrolló, por lo que cuando se lleva el sistema a un nuevo hospital, falla, y esa falla puede dirigir a los médicos hacia un diagnóstico y un tratamiento incorrectos”, explicó el estudiante de posgrado y coautor principal, Alex DeGrave. “Un médico generalmente esperaría que un hallazgo de COVID-19 en una radiografía se basara en patrones específicos en la imagen que reflejan los procesos de la enfermedad. Pero en lugar de depender de esos patrones, un sistema que utilice el aprendizaje de atajos podría, por ejemplo, juzgar que alguien es mayor y, por lo tanto, inferir que es más probable que tenga la enfermedad porque es más común en pacientes mayores. El atajo no es incorrecto per se, pero la asociación es inesperada y no transparente. Y eso podría llevar a un diagnóstico inadecuado”.

“Nuestros hallazgos apuntan a la importancia de aplicar técnicas de inteligencia artificial explicables para auditar rigurosamente los sistemas de inteligencia artificial médica”, dijo el coautor principal Joseph Janizek. “Si miras un puñado de rayos X, el sistema de IA puede parecer que se comporta bien. Los problemas solo se aclaran una vez que miras muchas imágenes. Hasta que tengamos métodos para auditar estos sistemas de manera más eficiente utilizando un tamaño de muestra mayor, una aplicación más sistemática de IA explicable podría ayudar a los investigadores a evitar algunos de los errores que identificamos con los modelos COVID-19”.

Enlace relacionado:

Facultad de Ciencias e Ingeniería Informática Paul G. Allen de la Universidad de Washington

Últimas COVID-19 noticias

- Inmunosensor nuevo allana el camino para pruebas rápidas POC para COVID-19 y enfermedades infecciosas emergentes

- Encuentran etiologías de COVID prolongada en muestras de sangre con infección aguda

- Dispositivo novedoso detecta anticuerpos contra la COVID-19 en cinco minutos

- Prueba para COVID-19 mediante CRISPR detecta SARS-CoV-2 en 30 minutos usando tijeras genéticas

- Asocian disbiosis del microbioma intestinal con la COVID-19

- Validan prueba rápida novedosa de antígeno para el SARS-CoV-2 con respecto a su exactitud diagnóstica

- Prueba nueva COVID + Influenza + VSR ayudará a estar preparados para la ‘tripledemia’

- IA elimina las conjeturas de las pruebas de flujo lateral

- Prueba de antígeno del SARS-CoV-2 más rápida, jamás diseñada, permite realizar pruebas de COVID-19 no invasivas en cualquier entorno

- Pruebas rápidas de antígeno detectan las variantes ómicron, delta del SARS-CoV-2

- Prueba en sangre realizada durante la infección inicial predice el riesgo de COVID prolongada

- Investigadores afirman que hay que crear “reservistas” de laboratorio para responder más rápidamente a la próxima pandemia

- Estudio encuentra que los profesionales sanitarios mostraron mayor interés en tecnologías POC durante la pandemia

- Plataforma de análisis de bajo costo para la COVID-19 combina sensibilidad de la PCR y velocidad de pruebas de antígeno

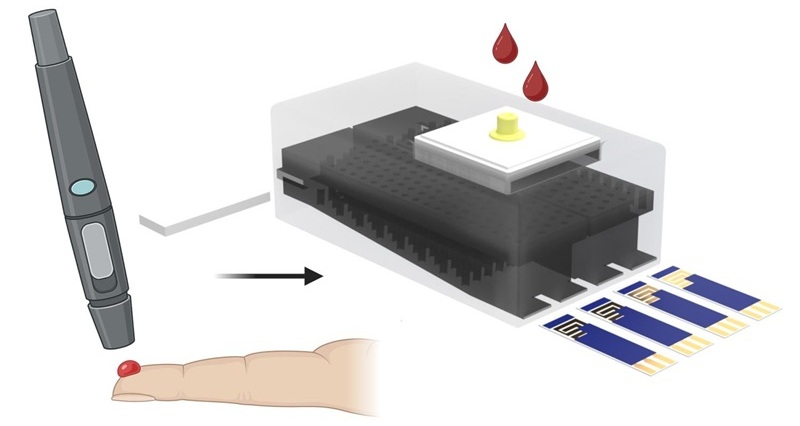

- Prueba de sangre por punción digital identifica inmunidad a la COVID-19

- Kit de prueba rápida determina inmunidad contra la COVID-19 y sus variantes

Canales

Química Clínica

ver canal

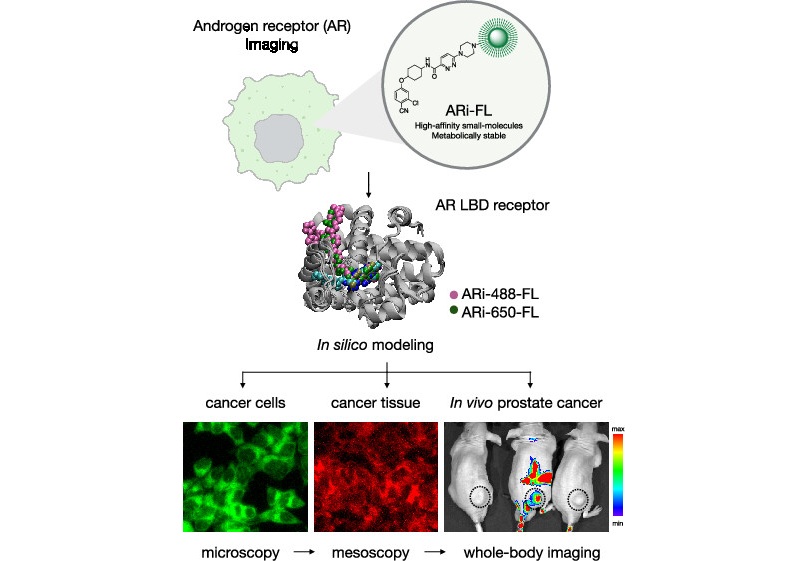

Sonda de imágenes químicas podría rastrear y tratar cáncer de próstata

El cáncer de próstata sigue siendo una de las principales causas de enfermedad y muerte en hombres, y muchos pacientes desarrollan resistencia a las terapias hormonales bloqueantes convencionales.... Más

Discrepancia entre dos pruebas comunes de función renal indica problemas de salud graves

La creatinina ha sido durante mucho tiempo el método estándar para medir la filtración renal, mientras que la cistatina C, una proteína producida por todas las células humanas, se ha recomendado como marcador... MásDiagnóstico Molecular

ver canal

Sencilla prueba de orina revolucionará diagnóstico y tratamiento del cáncer de vejiga

El cáncer de vejiga es uno de los cánceres urológicos más comunes y mortales, y se caracteriza por una alta tasa de recurrencia. El diagnóstico y el seguimiento aún... Más

Análisis snaguíneo para detección más temprana y sencilla de fibrosis hepática

El daño hepático persistente causado por el abuso de alcohol o infecciones virales puede desencadenar fibrosis hepática, una afección en la que el tejido sano se reemplaza gradualmente... MásHematología

ver canal

Análisis sanguíneo de actividad plaquetaria en mediana edad podría identificar riesgo temprano de Alzheimer

La detección temprana de la enfermedad de Alzheimer sigue siendo una de las mayores necesidades insatisfechas en neurología, sobre todo porque los cambios biológicos que subyacen al... Más

Medición de microvesículas podría detectar lesiones vasculares en pacientes con anemia falciforme

Evaluar la gravedad de la enfermedad de células falciformes (ECF) sigue siendo un reto, sobre todo al intentar predecir la hemólisis, el daño vascular y el riesgo de complicaciones... MásInmunología

ver canal

Nueva prueba distingue falsos positivos inducidos por vacuna de infección activa por VIH

Desde que se identificó el VIH en 1983, más de 91 millones de personas han contraído el virus y más de 44 millones han fallecido por causas relacionadas. Hoy en día, casi 40 millones de personas en todo... Más

Prueba de firma genética predice respuesta a tratamientos clave para cáncer de mama

Los inhibidores de DK4/6, combinados con terapia hormonal, se han convertido en un tratamiento fundamental para el cáncer de mama avanzado HR+/HER2–, ya que ralentizan el crecimiento tumoral... MásMicrobiología

ver canal

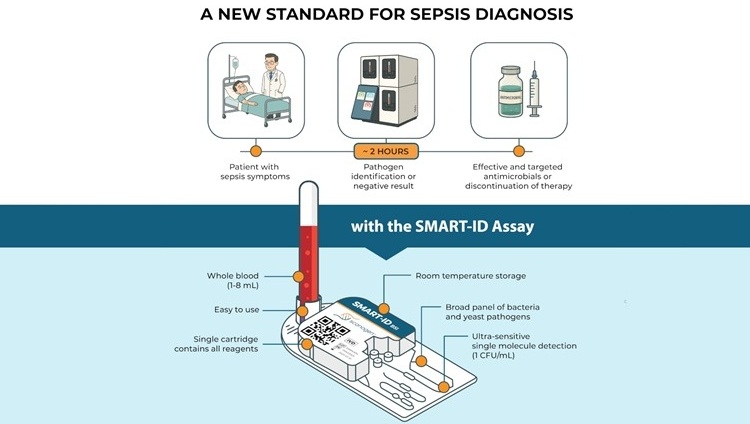

Prueba de diagnóstico rápido es estándar de oro para detección de sepsis

La sepsis causa la muerte de 11 millones de personas en todo el mundo cada año y genera enormes costos de atención médica. Solo en EUA y Europa, la sepsis representa 100.... MásPrueba rápida de tuberculosis POC proporciona resultados en 15 minutos

La tuberculosis sigue siendo una de las enfermedades infecciosas más mortales del mundo, y la reducción de nuevos casos depende de la identificación de las personas con infección... MásPatología

ver canal

Problemas de salud comunes pueden influir en nuevos análisis sanguíneos para enfermedad de Alzheimer

Las pruebas de sangre para la enfermedad de Alzheimer están transformando el diagnóstico al ofrecer una alternativa más sencilla a las punciones lumbares y las imágenes cerebrales.... Más

Fórmula de análisis sanguíneo identifica pacientes con enfermedad hepática crónica con mayor riesgo de cáncer

La enfermedad hepática crónica afecta a millones de personas en todo el mundo y puede progresar silenciosamente a carcinoma hepatocelular (CHC), uno de los cánceres más mortales... MásTecnología

ver canal

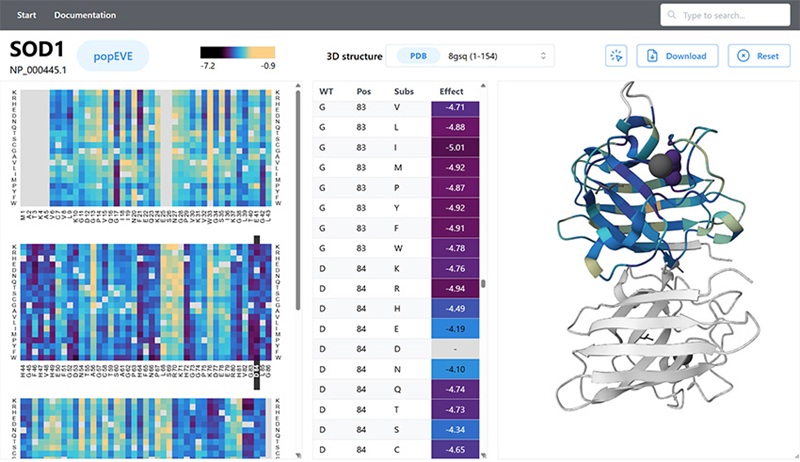

Modelo de inteligencia artificial podría acelerar diagnóstico de enfermedades raras

Identificar qué variantes genéticas causan enfermedades sigue siendo uno de los mayores desafíos de la medicina genómica. Cada persona porta decenas de miles de cambios en el... Más

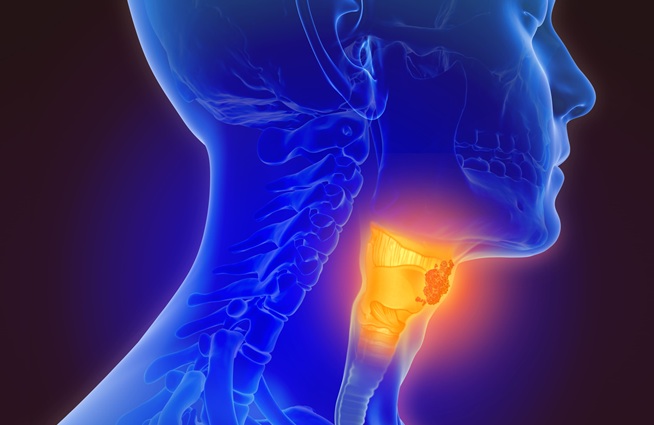

Sensor de saliva con IA permite detección precoz del cáncer de cabeza y cuello

La detección precoz del cáncer de cabeza y cuello sigue siendo difícil porque la enfermedad produce pocos o ningún síntoma en sus primeras etapas, y las lesiones a menudo... MásIndustria

ver canal

Abbott adquiere Exact Sciences, empresa de detección de cáncer

Abbott (Abbott Park, IL, EUA) ha firmado un acuerdo definitivo para adquirir Exact Sciences (Madison, WI, EUA), lo que le permitirá entrar y liderar en segmentos de diagnóstico de cáncer... Más

assay.jpg)